Apache Hadoop terdiri dari beberapa paket perangkat lunak sumber terbuka yang bekerja sama untuk penyimpanan terdistribusi dan pemrosesan data besar yang terdistribusi. Ada empat komponen utama Hadoop:

- Hadoop Umum – berbagai perpustakaan perangkat lunak yang Hadoop andalkan untuk dijalankan

- Sistem File Terdistribusi Hadoop (HDFS) – sistem file yang memungkinkan distribusi dan penyimpanan data besar secara efisien di seluruh cluster komputer

- Hadoop MapReduce – digunakan untuk mengolah data

- BENANG Hadoop – API yang mengelola alokasi sumber daya komputasi untuk seluruh cluster

Dalam tutorial ini, kita akan membahas langkah-langkah untuk menginstal Hadoop versi 3 di Ubuntu 20.04. Ini akan melibatkan penginstalan HDFS (Namenode dan Datanode), YARN, dan MapReduce pada satu node cluster yang dikonfigurasi dalam Pseudo Distributed Mode, yang merupakan simulasi terdistribusi pada satu mesin. Setiap komponen Hadoop (HDFS, YARN, MapReduce) akan berjalan pada node kita sebagai proses Java yang terpisah.

Dalam tutorial ini Anda akan mempelajari:

- Cara menambahkan pengguna untuk Lingkungan Hadoop

- Cara menginstal prasyarat Java

- Cara mengonfigurasi SSH tanpa kata sandi

- Cara menginstal Hadoop dan mengonfigurasi file XML terkait yang diperlukan

- Cara memulai Kluster Hadoop

- Cara mengakses NameNode dan ResourceManager Web UI

Apache Hadoop di Ubuntu 20.04 Focal Fossa

Apache Hadoop di Ubuntu 20.04 Focal Fossa| Kategori | Persyaratan, Konvensi, atau Versi Perangkat Lunak yang Digunakan |

|---|---|

| Sistem | Instal Ubuntu 20.04 atau upgrade Ubuntu 20.04 Focal Fossa |

| Perangkat Lunak | Apache Hadoop, Java |

| Lainnya | Akses istimewa ke sistem Linux Anda sebagai root atau melalui sudo perintah. |

| Konvensi | # – membutuhkan perintah linux yang diberikan untuk dieksekusi dengan hak akses root baik secara langsung sebagai pengguna root atau dengan menggunakan sudo perintah$ – membutuhkan perintah linux yang diberikan untuk dieksekusi sebagai pengguna biasa yang tidak memiliki hak istimewa |

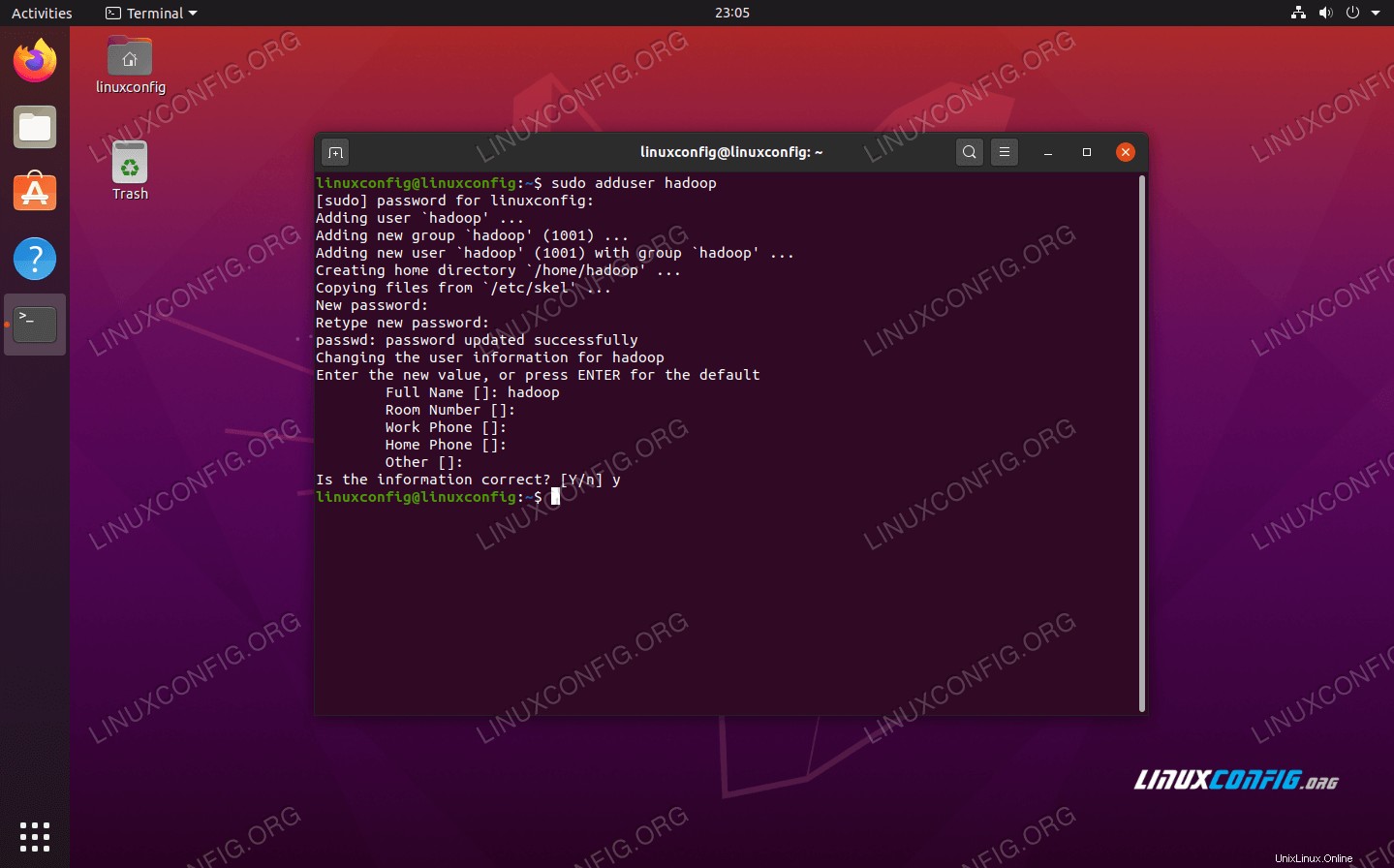

Buat pengguna untuk lingkungan Hadoop

Hadoop harus memiliki akun pengguna khusus di sistem Anda. Untuk membuatnya, buka terminal dan ketik perintah berikut. Anda juga akan diminta untuk membuat kata sandi untuk akun tersebut.

$ sudo adduser hadoop

Buat pengguna Hadoop baru

Buat pengguna Hadoop baru Instal prasyarat Java

Hadoop didasarkan pada Java, jadi Anda harus menginstalnya di sistem Anda sebelum dapat menggunakan Hadoop. Pada saat penulisan ini, Hadoop versi 3.1.3 saat ini membutuhkan Java 8, jadi itulah yang akan kami instal di sistem kami.

Gunakan dua perintah berikut untuk mengambil daftar paket terbaru di apt dan instal Java 8:

$ sudo apt update $ sudo apt install openjdk-8-jdk openjdk-8-jre

Konfigurasikan SSH tanpa kata sandi

Hadoop bergantung pada SSH untuk mengakses node-nya. Ini akan terhubung ke mesin jarak jauh melalui SSH serta mesin lokal Anda jika Anda menjalankan Hadoop. Jadi, meskipun kita hanya mengatur Hadoop di mesin lokal kita dalam tutorial ini, kita masih perlu menginstal SSH. Kita juga harus mengonfigurasi SSH tanpa kata sandi

sehingga Hadoop dapat secara diam-diam membuat koneksi di latar belakang.

- Kami membutuhkan paket OpenSSH Server dan OpenSSH Client. Instal dengan perintah ini:

$ sudo apt install openssh-server openssh-client

- Sebelum melanjutkan lebih jauh, sebaiknya login ke

hadoopakun pengguna yang kita buat sebelumnya. Untuk mengubah pengguna di terminal Anda saat ini, gunakan perintah berikut:$ su hadoop

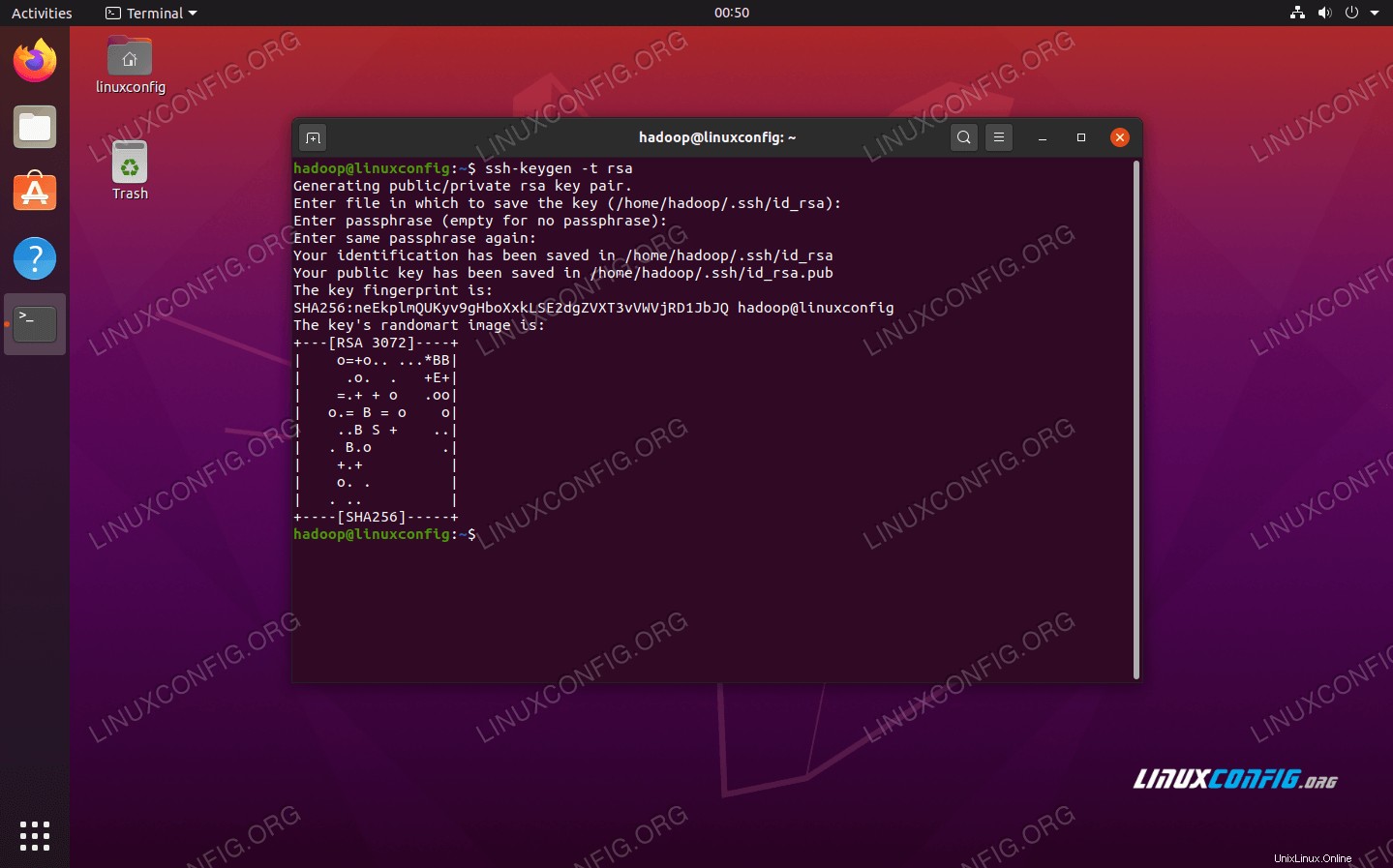

- Dengan paket-paket tersebut terinstal, saatnya untuk membuat pasangan kunci publik dan pribadi dengan perintah berikut. Perhatikan bahwa terminal akan meminta Anda beberapa kali, tetapi yang perlu Anda lakukan hanyalah terus menekan

ENTERuntuk melanjutkan.$ ssh-keygen -t rsa

Membuat kunci RSA untuk SSH tanpa kata sandi

Membuat kunci RSA untuk SSH tanpa kata sandi - Selanjutnya, salin kunci RSA yang baru dibuat di

id_rsa.pubkeauthorized_keys:$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

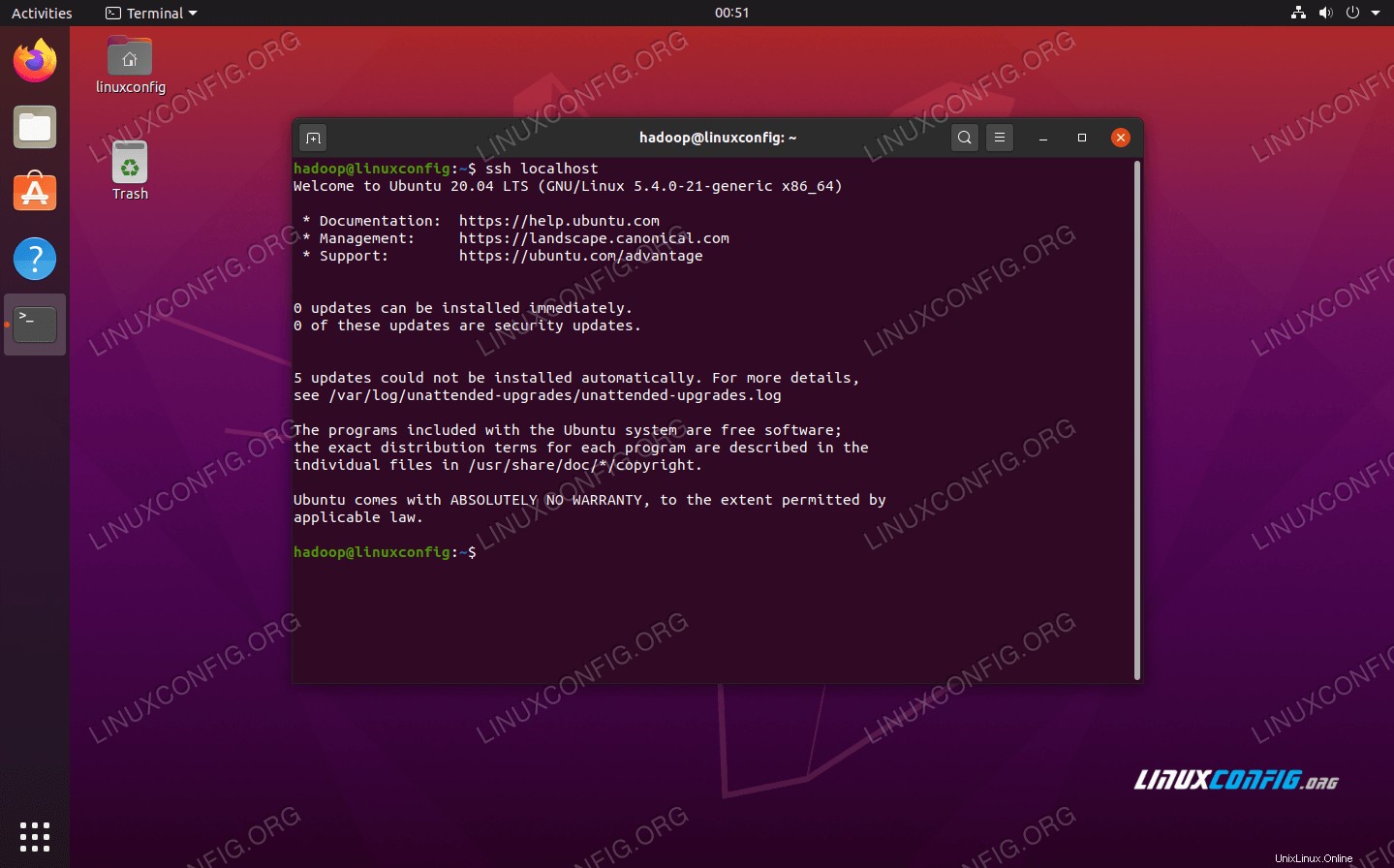

- Anda dapat memastikan bahwa konfigurasi berhasil dengan SSHing ke localhost. Jika Anda dapat melakukannya tanpa dimintai kata sandi, Anda siap melakukannya.

Masuk ke sistem tanpa diminta kata sandi berarti berhasil

Masuk ke sistem tanpa diminta kata sandi berarti berhasil

Instal Hadoop dan konfigurasikan file XML terkait

Buka situs web Apache untuk mengunduh Hadoop. Anda juga dapat menggunakan perintah ini jika Anda ingin mengunduh biner Hadoop versi 3.1.3 secara langsung:

$ wget https://downloads.apache.org/hadoop/common/hadoop-3.1.3/hadoop-3.1.3.tar.gz

Ekstrak unduhan ke hadoop direktori home pengguna dengan perintah ini:

$ tar -xzvf hadoop-3.1.3.tar.gz -C /home/hadoop

Menyiapkan variabel lingkungan

Berikut export perintah akan mengonfigurasi variabel lingkungan Hadoop yang diperlukan pada sistem kami. Anda dapat menyalin dan menempelkan semua ini ke terminal Anda (Anda mungkin perlu mengubah baris 1 jika Anda memiliki versi Hadoop yang berbeda):

export HADOOP_HOME=/home/hadoop/hadoop-3.1.3

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native"

Sumber .bashrc file dalam sesi login saat ini:

$ source ~/.bashrc

Selanjutnya, kita akan membuat beberapa perubahan pada hadoop-env.sh file, yang dapat ditemukan di direktori instalasi Hadoop di bawah /etc/hadoop . Gunakan nano atau editor teks favorit Anda untuk membukanya:

$ nano ~/hadoop-3.1.3/etc/hadoop/hadoop-env.sh

Ubah JAVA_HOME variabel ke tempat Java diinstal. Di sistem kami (dan mungkin milik Anda juga, jika Anda menjalankan Ubuntu 20.04 dan telah mengikuti kami sejauh ini), kami mengubah baris itu menjadi:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

Ubah variabel lingkungan Java_HOME

Ubah variabel lingkungan Java_HOME Itu akan menjadi satu-satunya perubahan yang perlu kita lakukan di sini. Anda dapat menyimpan perubahan ke file dan menutupnya.

Perubahan konfigurasi dalam file core-site.xml

Perubahan selanjutnya yang perlu kita lakukan adalah di dalam core-site.xml mengajukan. Buka dengan perintah ini:

$ nano ~/hadoop-3.1.3/etc/hadoop/core-site.xml

Masukkan konfigurasi berikut, yang menginstruksikan HDFS untuk dijalankan pada port localhost 9000 dan menyiapkan direktori untuk data sementara.

fs.defaultFS

hdfs://localhost:9000

hadoop.tmp.dir

/home/hadoop/hadooptmpdata

perubahan file konfigurasi core-site.xml

perubahan file konfigurasi core-site.xml Simpan perubahan Anda dan tutup file ini. Kemudian, buat direktori tempat data sementara akan disimpan:

$ mkdir ~/hadooptmpdata

Perubahan konfigurasi pada file hdfs-site.xml

Buat dua direktori baru untuk Hadoop untuk menyimpan informasi Namenode dan Datanode.

$ mkdir -p ~/hdfs/namenode ~/hdfs/datanode

Kemudian, edit file berikut untuk memberi tahu Hadoop di mana menemukan direktori tersebut:

$ nano ~/hadoop-3.1.3/etc/hadoop/hdfs-site.xml

Buat perubahan berikut pada hdfs-site.xml file, sebelum menyimpan dan menutupnya:

dfs.replication

1

dfs.name.dir

file:///home/hadoop/hdfs/namenode

dfs.data.dir

file:///home/hadoop/hdfs/datanode

perubahan file konfigurasi hdfs-site.xml

perubahan file konfigurasi hdfs-site.xml Perubahan konfigurasi pada file mapred-site.xml

Buka file konfigurasi MapReduce XML dengan perintah berikut:

$ nano ~/hadoop-3.1.3/etc/hadoop/mapred-site.xml

Dan buat perubahan berikut sebelum menyimpan dan menutup file:

mapreduce.framework.name

yarn

perubahan file konfigurasi mapred-site.xml

perubahan file konfigurasi mapred-site.xml Perubahan konfigurasi pada file yarn-site.xml

Buka file konfigurasi YARN dengan perintah berikut:

$ nano ~/hadoop-3.1.3/etc/hadoop/yarn-site.xml

Tambahkan entri berikut dalam file ini, sebelum menyimpan perubahan dan menutupnya:

mapreduceyarn.nodemanager.aux-services

mapreduce_shuffle

perubahan file konfigurasi situs benang

perubahan file konfigurasi situs benang Memulai cluster Hadoop

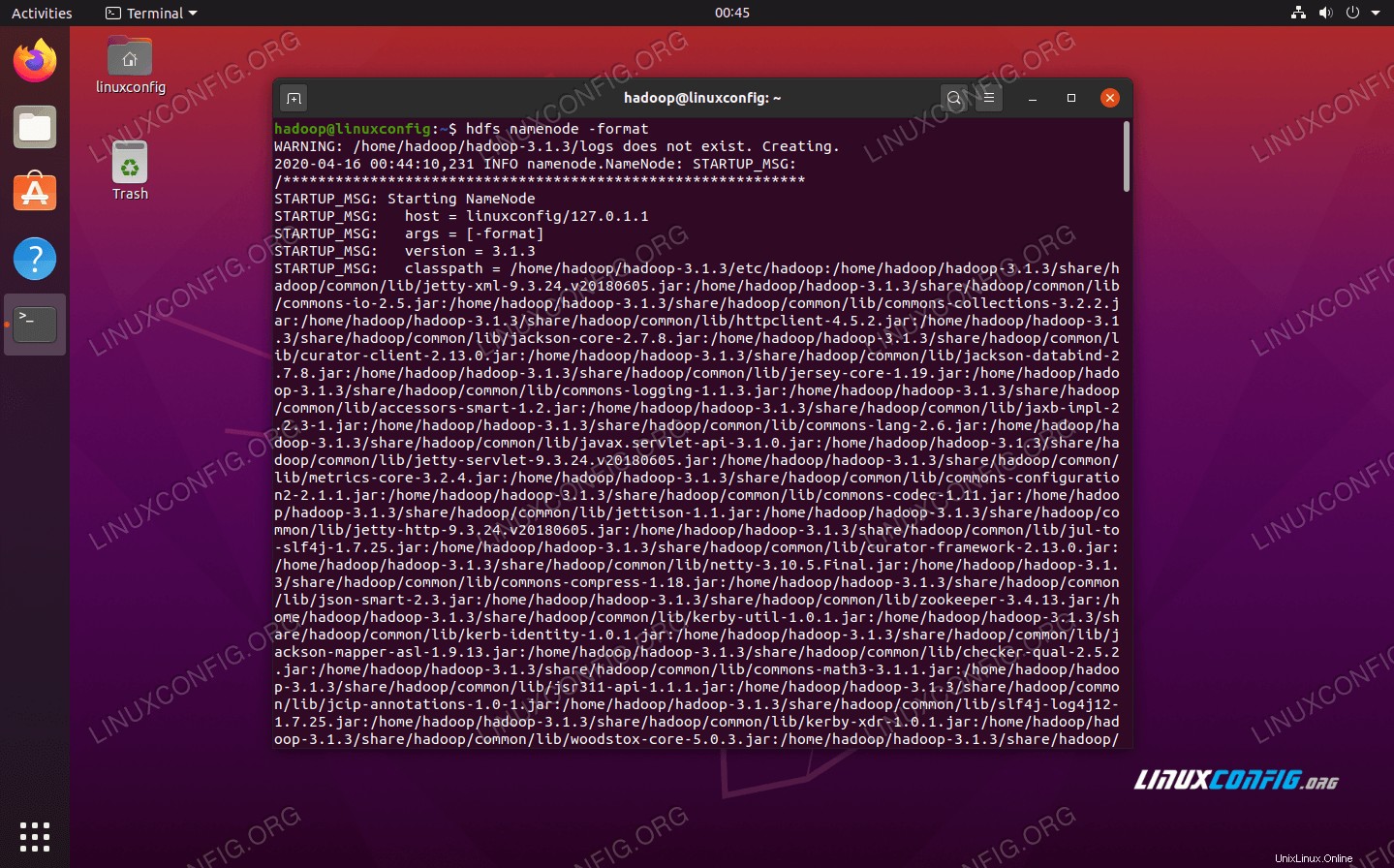

Sebelum menggunakan cluster untuk pertama kalinya, kita perlu memformat namenode. Anda dapat melakukannya dengan perintah berikut:

$ hdfs namenode -format

Memformat Node Nama HDFS

Memformat Node Nama HDFS Terminal Anda akan mengeluarkan banyak informasi. Selama Anda tidak melihat pesan kesalahan apa pun, Anda dapat menganggapnya berhasil.

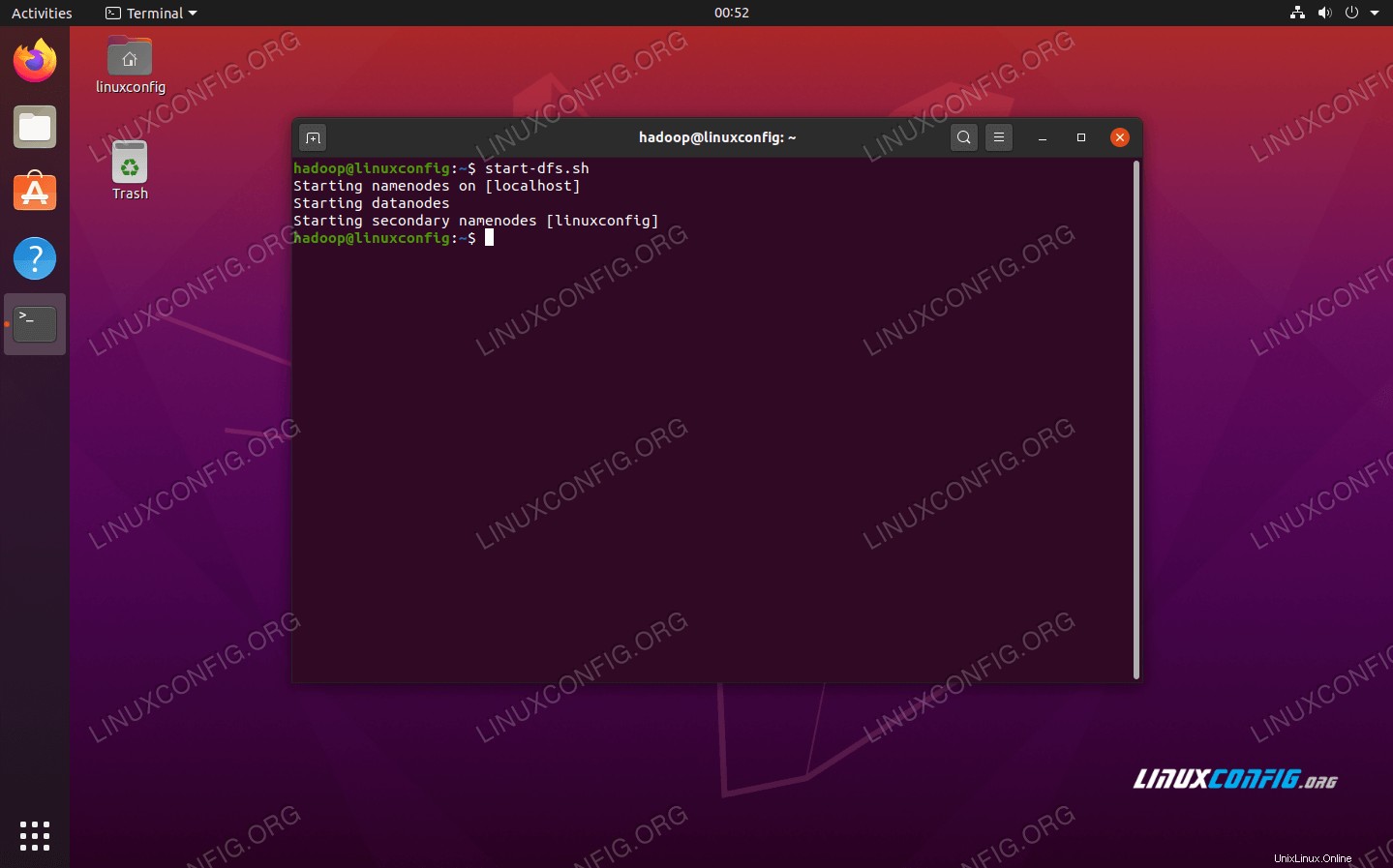

Selanjutnya, jalankan HDFS dengan menggunakan start-dfs.sh naskah:

$ start-dfs.sh

Jalankan skrip start-dfs.sh

Jalankan skrip start-dfs.sh

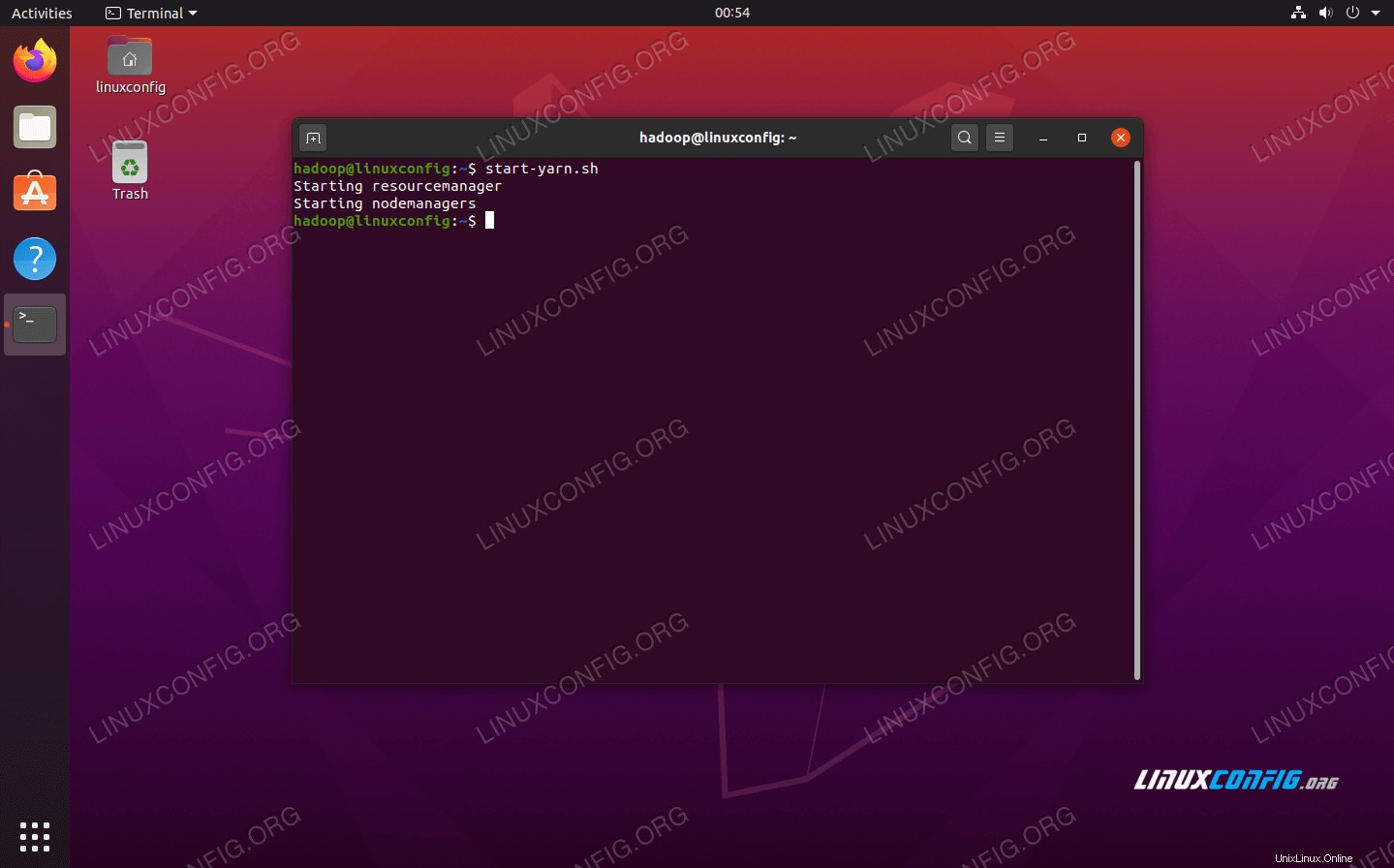

Sekarang, mulai layanan YARN melalui start-yarn.sh naskah:

$ start-yarn.sh

Jalankan skrip start-yarn.sh

Jalankan skrip start-yarn.sh

Untuk memverifikasi semua layanan Hadoop/daemon dimulai dengan sukses, Anda dapat menggunakan jps memerintah. Ini akan menampilkan semua proses yang saat ini menggunakan Java yang berjalan di sistem Anda.

$ jps

Jalankan jps untuk melihat semua proses yang bergantung pada Java dan memverifikasi bahwa komponen Hadoop sedang berjalan

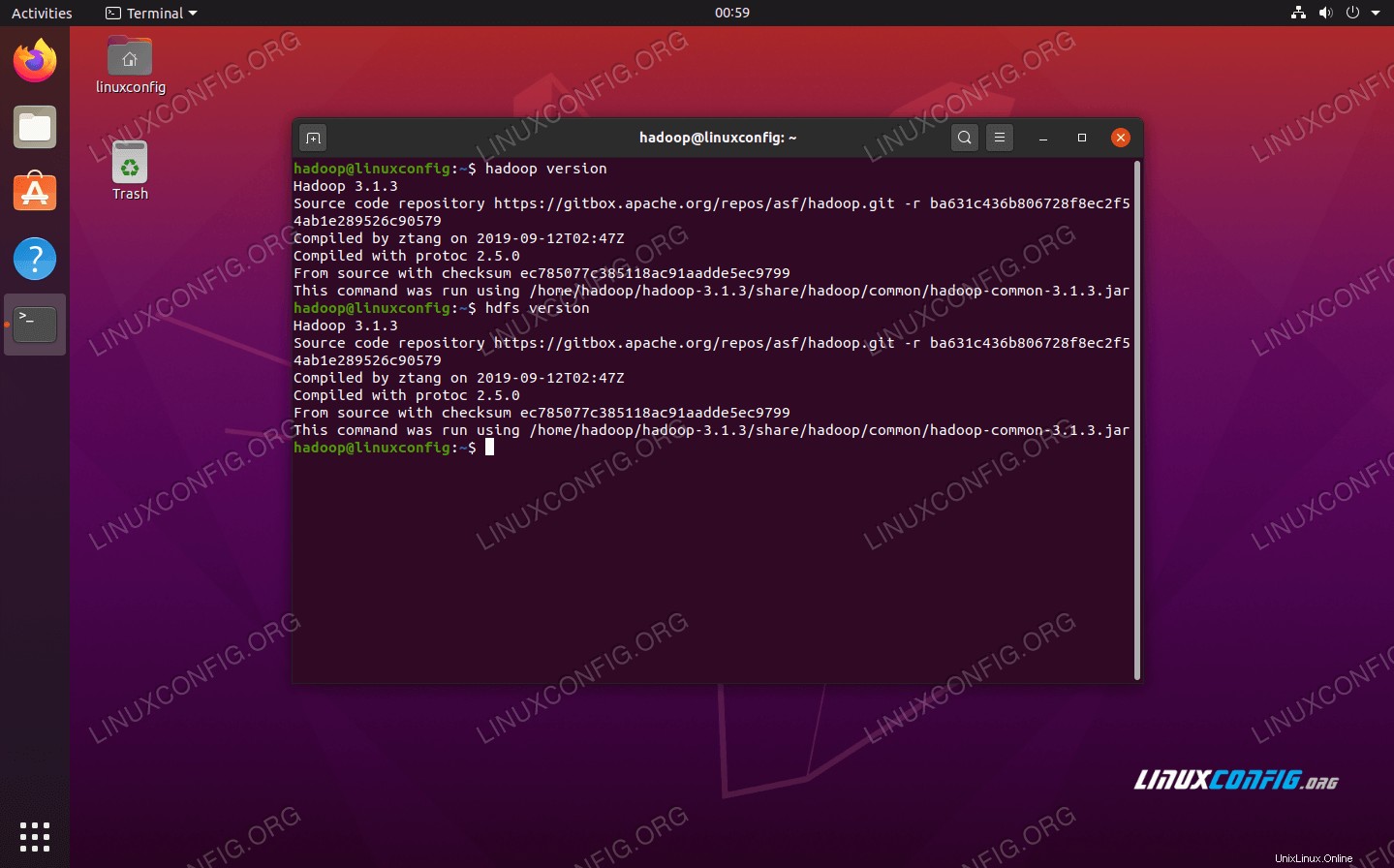

Jalankan jps untuk melihat semua proses yang bergantung pada Java dan memverifikasi bahwa komponen Hadoop sedang berjalan Sekarang kita dapat memeriksa versi Hadoop saat ini dengan salah satu dari perintah berikut:

$ hadoop version

atau

$ hdfs version

Memverifikasi instalasi Hadoop dan versi saat ini

Memverifikasi instalasi Hadoop dan versi saat ini Antarmuka Baris Perintah HDFS

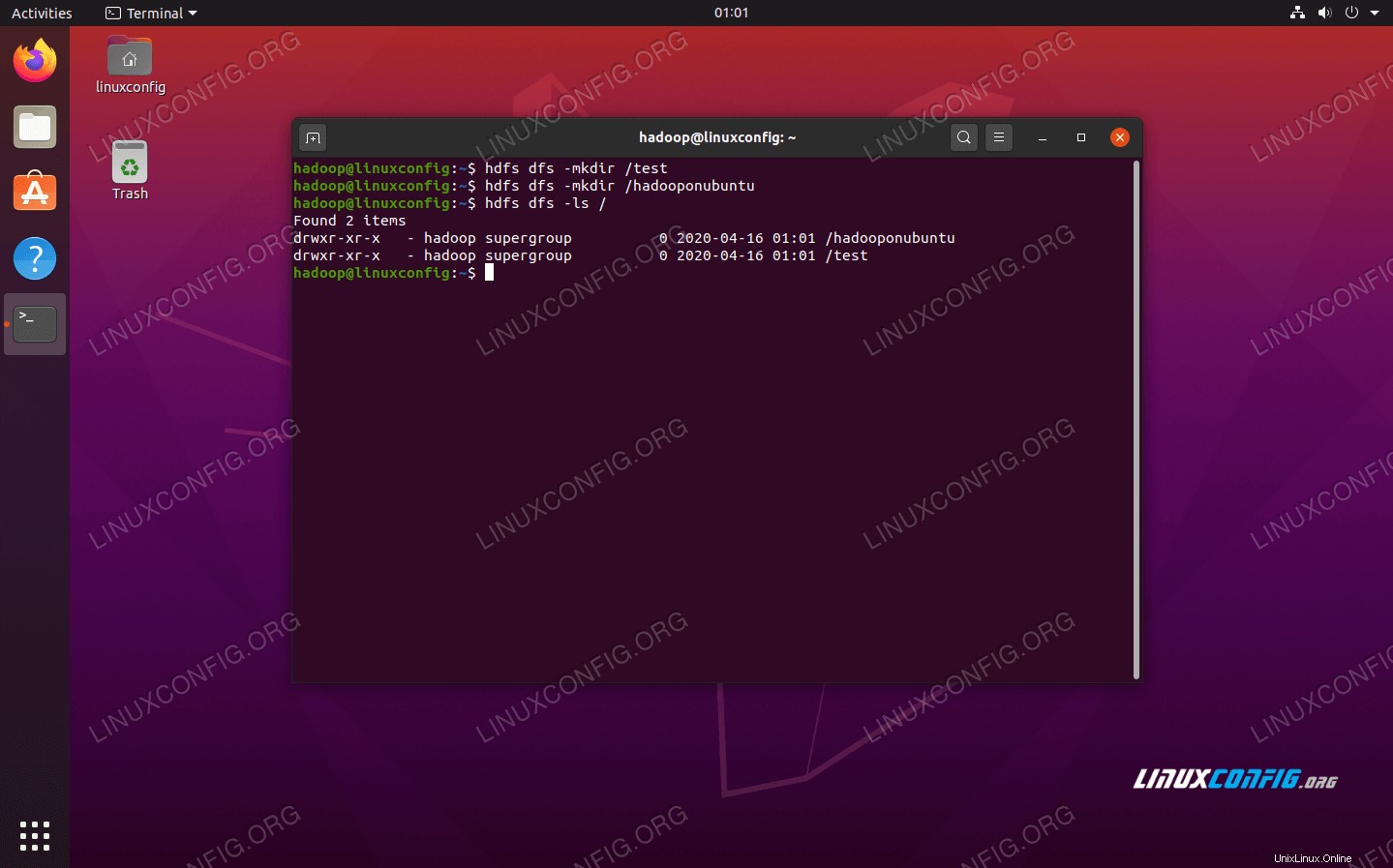

Baris perintah HDFS digunakan untuk mengakses HDFS dan untuk membuat direktori atau mengeluarkan perintah lain untuk memanipulasi file dan direktori. Gunakan sintaks perintah berikut untuk membuat beberapa direktori dan daftar mereka:

$ hdfs dfs -mkdir /test $ hdfs dfs -mkdir /hadooponubuntu $ hdfs dfs -ls /

Berinteraksi dengan baris perintah HDFS

Berinteraksi dengan baris perintah HDFS Akses Namenode dan YARN dari browser

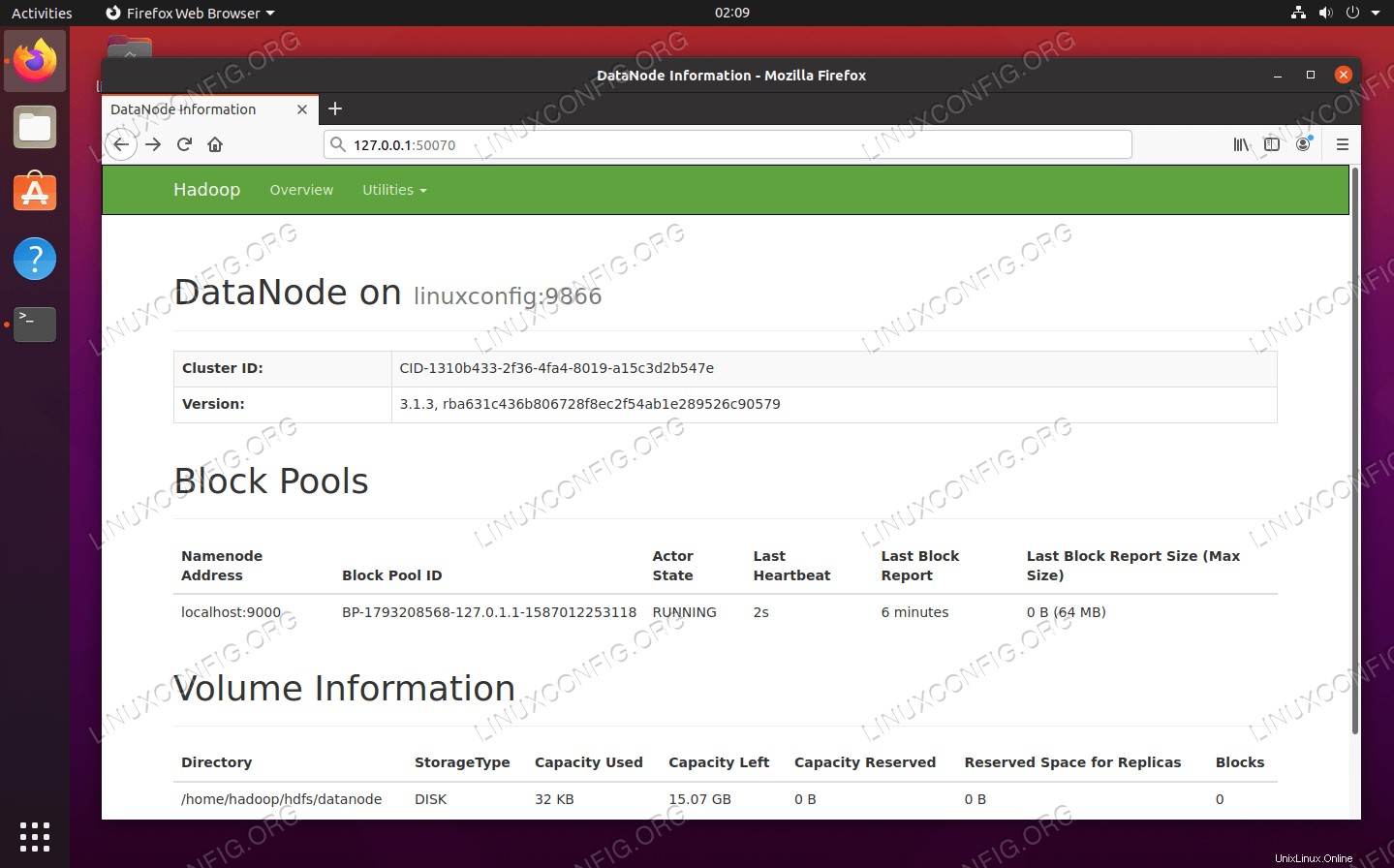

Anda dapat mengakses UI Web untuk NameNode dan YARN Resource Manager melalui browser pilihan Anda, seperti Mozilla Firefox atau Google Chrome.

Untuk UI Web NameNode, navigasikan ke http://HADOOP-HOSTNAME-OR-IP:50070

Antarmuka web DataNode untuk Hadoop

Antarmuka web DataNode untuk Hadoop

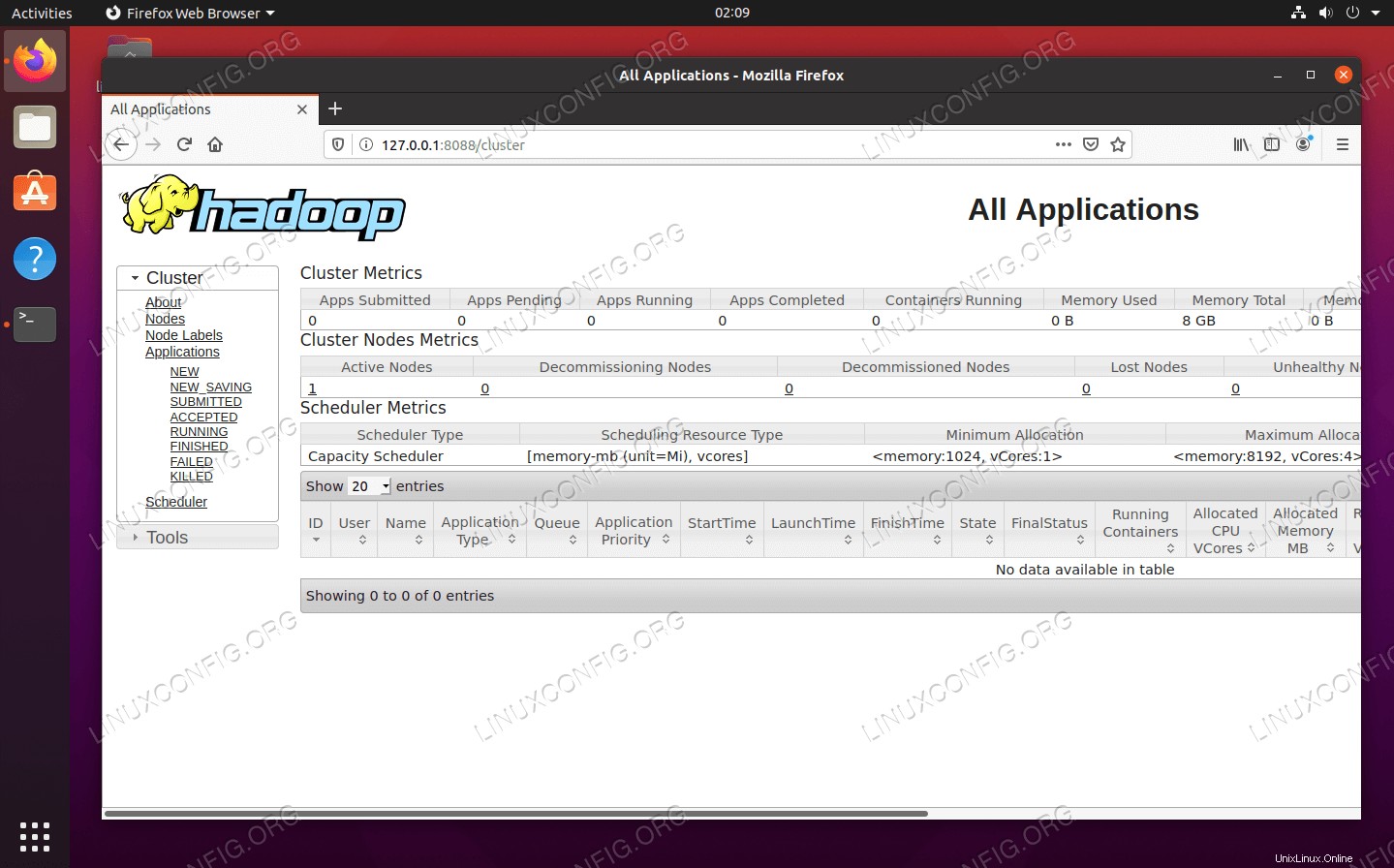

Untuk mengakses antarmuka web YARN Resource Manager, yang akan menampilkan semua pekerjaan yang sedang berjalan di cluster Hadoop, navigasikan ke http://HADOOP-HOSTNAME-OR-IP:8088

Antarmuka web YARN Resource Manager untuk Hadoop

Antarmuka web YARN Resource Manager untuk Hadoop Kesimpulan

Pada artikel ini, kita melihat cara menginstal Hadoop pada cluster node tunggal di Ubuntu 20.04 Focal Fossa. Hadoop memberi kami solusi praktis untuk menangani data besar, memungkinkan kami menggunakan kluster untuk penyimpanan dan pemrosesan data kami. Itu membuat hidup kita lebih mudah saat bekerja dengan kumpulan data yang besar dengan konfigurasi yang fleksibel dan antarmuka web yang nyaman.