Pengantar

Apache Spark adalah kerangka kerja komputasi terdistribusi sumber terbuka yang dibuat untuk memberikan hasil komputasi yang lebih cepat.

Ini adalah mesin komputasi dalam memori, artinya data akan diproses dalam memori.

Percikan mendukung berbagai API untuk streaming, pemrosesan grafik, SQL, MLLib. Ini juga mendukung Java, Python, Scala, dan R sebagai bahasa pilihan. Spark kebanyakan dipasang di cluster Hadoop tetapi Anda juga dapat menginstal dan mengonfigurasi spark dalam mode mandiri.

Pada artikel ini, kita akan melihat cara menginstal Apache Spark di Debian dan Ubuntu -distribusi berbasis.

Instal Java di Ubuntu

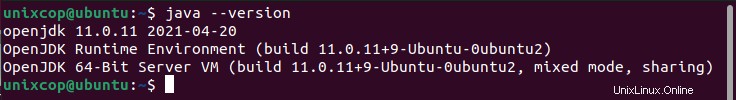

Untuk menginstal Apache Spark di Ubuntu, Anda harus memiliki Java diinstal pada mesin Anda. Sebagian besar distribusi modern datang dengan Java yang terinstal secara default dan Anda dapat memverifikasinya menggunakan perintah berikut.

$ java -version

Jika tidak ada output, Anda dapat menginstal Java menggunakan artikel kami tentang cara menginstal Java di Ubuntu atau cukup jalankan perintah berikut untuk menginstal Java di Ubuntu dan distribusi berbasis Debian.

$ sudo apt update

$ sudo apt install default-jre

$ java -versionInstal Scala di Ubuntu

Selanjutnya, Anda dapat menginstal Scala dari repositori apt dengan menjalankan perintah berikut untuk mencari scala dan menginstalnya.

Cari paket

$ sudo apt search scalaInstal paket

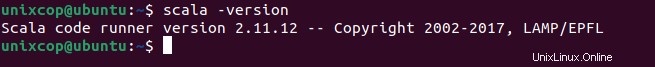

$ sudo apt install scala -yUntuk memverifikasi pemasangan Scala , jalankan perintah berikut.

$ scala -version

Instal Apache Spark di Ubuntu

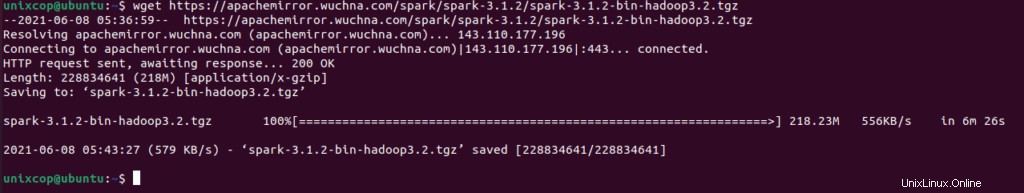

Sekarang buka halaman unduhan Apache Spark resmi dan ambil versi terbaru (yaitu 3.1.2) pada saat menulis artikel ini. Atau, Anda dapat menggunakan perintah wget untuk mengunduh file secara langsung di terminal.

$ wget https://apachemirror.wuchna.com/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz

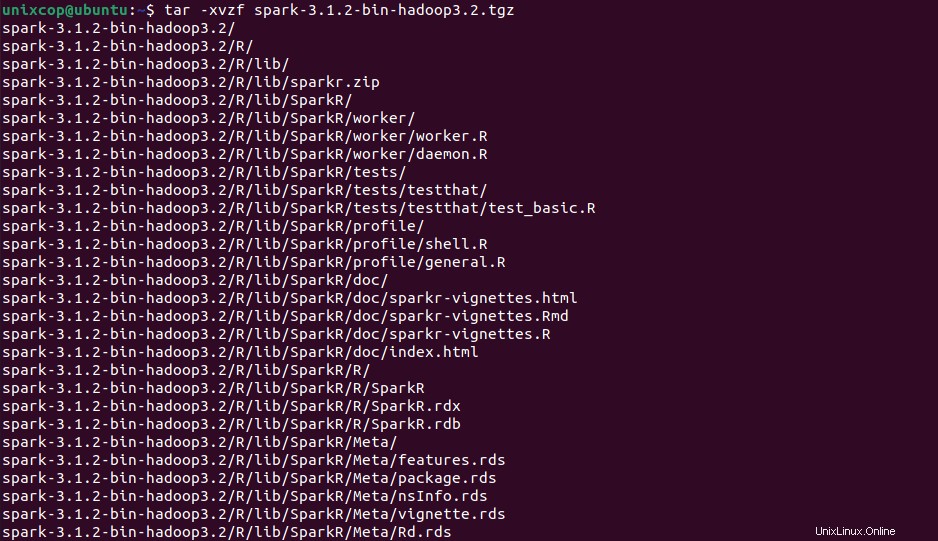

Sekarang buka terminal Anda dan alihkan ke tempat file yang diunduh ditempatkan dan jalankan perintah berikut untuk mengekstrak file tar Apache Spark.

$ tar -xvzf spark-3.1.2-bin-hadoop3.2.tgz

Terakhir, pindahkan Spark . yang telah diekstrak direktori ke /opt direktori.

sudo mv spark-3.1.2-bin-hadoop3.2 /opt/sparkKonfigurasikan Variabel untuk Spark

Sekarang Anda harus menyetel beberapa variabel lingkungan di .profil . Anda file sebelum memulai percikan.

$ echo "export SPARK_HOME=/opt/spark" >> ~/.profile

$ echo "export PATH=$PATH:/opt/spark/bin:/opt/spark/sbin" >> ~/.profile

$ echo "export PYSPARK_PYTHON=/usr/bin/python3" >> ~/.profileUntuk memastikan bahwa variabel lingkungan baru ini dapat dijangkau dalam shell dan tersedia untuk Apache Spark, Anda juga wajib menjalankan perintah berikut untuk menerapkan perubahan terbaru.

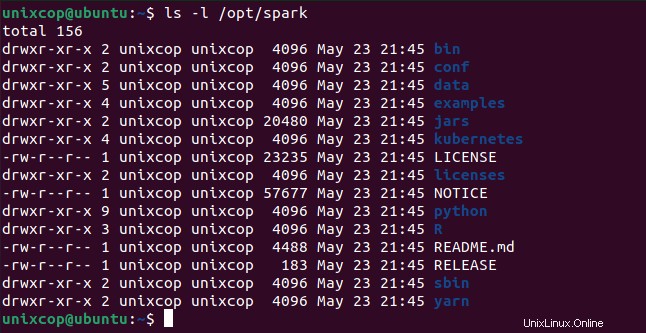

$ source ~/.profileSemua binari terkait percikan untuk memulai dan menghentikan layanan berada di bawah sbin folder.

$ ls -l /opt/spark

Mulai Apache Spark di Ubuntu

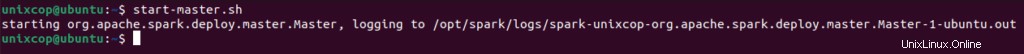

Jalankan perintah berikut untuk memulai Spark layanan master dan layanan budak.

$ start-master.sh

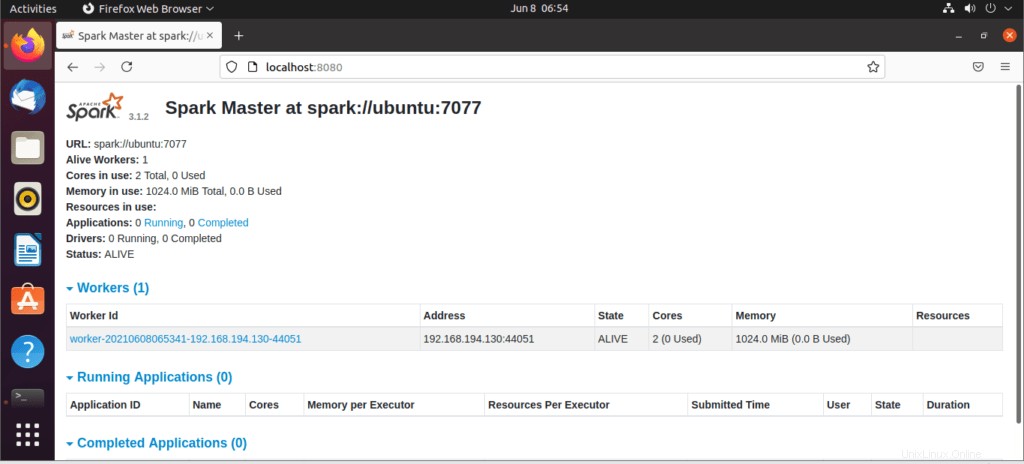

Setelah layanan dimulai, buka browser dan ketik halaman percikan akses URL berikut. Dari halaman tersebut, Anda dapat melihat layanan master saya dimulai.

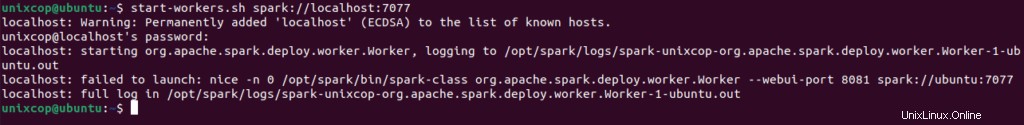

http://localhost:8080/Kemudian Anda dapat menambahkan pekerja dengan perintah ini :

$ start-workers.sh spark://localhost:7077

Pekerja akan ditambahkan seperti yang ditunjukkan:

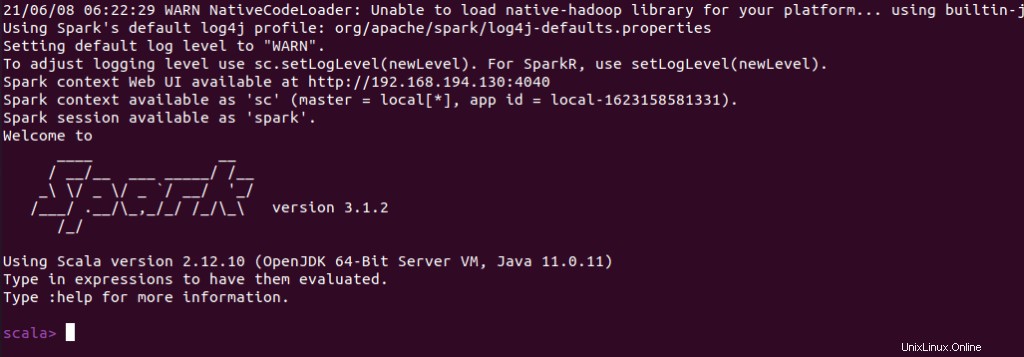

Anda juga dapat memeriksa apakah spark-shell berfungsi dengan baik dengan meluncurkan spark-shell perintah.

$ spark-shell