NFS (Network File System) adalah server yang paling banyak menyediakan file melalui jaringan. Dengan server NFS kami dapat berbagi folder melalui jaringan dan klien atau sistem yang diizinkan dapat mengakses folder bersama tersebut dan dapat menggunakannya dalam aplikasi mereka. Ketika datang ke lingkungan produksi maka kita harus mengonfigurasi server nfs dalam ketersediaan tinggi untuk mengesampingkan satu titik kegagalan.

Pada artikel ini kita akan membahas bagaimana kita dapat mengkonfigurasi clustering ketersediaan tinggi server nfs (aktif-pasif) dengan alat pacu jantung di CentOS 7 atau RHEL 7

Berikut adalah detail lab saya yang telah saya gunakan untuk artikel ini,

- NFS Server 1 (nfs1.example.com) – 192.168.1.40 – Minimal CentOS 7 / RHEL 7

- NFS Server 2 (nfs2.example.com) – 192.168.1.50 – Minimal CentOS 7 / RHEL 7

- VIP Server NFS – 192.168.1.51

- Firewall diaktifkan

- SELinux diaktifkan

Lihat langkah-langkah di bawah ini untuk mengonfigurasi pengelompokan aktif-pasif NFS Server di CentOS 7 / RHEL 7

Langkah 1) Tetapkan nama Host di kedua server nfs dan perbarui file /etc/hosts

Masuk ke kedua server nfs dan atur nama host sebagai "nfs1.example.com" dan "nfs2.example.com" masing-masing menggunakan perintah hostnamectl, Contoh ditunjukkan di bawah ini

~]# hostnamectl set-hostname "nfs1.example.com"~]# exec bash

Perbarui file /etc/hosts di kedua server nfs,

192.168.1.40 nfs1.example.com192.168.1.50 nfs2.example.com

Langkah 2) Perbarui kedua server nfs dan instal paket pcs

Gunakan perintah 'yum update' di bawah ini untuk menerapkan semua pembaruan di kedua server nfs dan kemudian reboot sekali.

~]# yum perbarui &&reboot

Instal paket pcs dan fence-agent di kedua server nfs,

[[email protected] ~]# yum install -y pcs fence-agents-all[[email protected] ~]# yum install -y pcs fence-agents-all

Setelah paket pcs dan agen pagar diinstal, izinkan port terkait pcs di firewall OS dari kedua server nfs,

~]# firewall-cmd --permanent --add-service=high-availability~]# firewall-cmd --reload

Sekarang Mulai dan aktifkan layanan pcsd pada kedua node nfs menggunakan perintah di bawah,

~]# systemctl aktifkan pcsd~]# systemctl start pcsd

Langkah 3) Otentikasi node nfs dan bentuk cluster

Setel kata sandi ke pengguna hacluster, layanan pcsd akan menggunakan pengguna ini untuk mendapatkan otentikasi node cluster, jadi pertama-tama atur kata sandi ke pengguna hacluster di kedua node,

[[email protected] ~]# echo "enter_password" | passwd --stdin hacluster[[email protected] ~]# echo "enter_password" | passwd --stdin hacluster

Sekarang autentikasi node Cluster, Dalam kasus kami nfs2.example.com akan diautentikasi pada nfs1.example.com, jalankan perintah pcs cluster di bawah ini pada “nfs1”

[[email protected] ~]# pcs cluster auth nfs1.example.com nfs2.example.comUsername:haclusterPassword:nfs1.example.com:Authorizednfs2.example.com:Authorized[[email protected] ~]#Sekarang saatnya membentuk cluster dengan nama “nfs_cluster ” dan tambahkan kedua node nfs ke dalamnya. Jalankan di bawah “pengaturan kluster pcs ” perintah dari simpul nfs mana pun,

[[email protected] ~]# pcs penyiapan cluster --start --name nfs_cluster nfs1.example.com \ nfs2.example.comAktifkan layanan pcs cluster di kedua node sehingga node akan bergabung dengan cluster secara otomatis setelah reboot. Jalankan perintah di bawah ini dari salah satu simpul nfs,

[[email protected] ~]# pcs cluster aktifkan --allnfs1.example.com:Cluster Enablednfs2.example.com:Cluster Enabled[[email protected] ~]#Langkah 4) Tentukan perangkat Anggar untuk setiap node cluster

Anggar adalah bagian terpenting dari sebuah cluster, jika salah satu node rusak maka perangkat pagar akan menghapus node tersebut dari cluster. Di Pacemaker, anggar ditentukan menggunakan sumber daya Stonith (Tembak Node Lain Di Kepala).

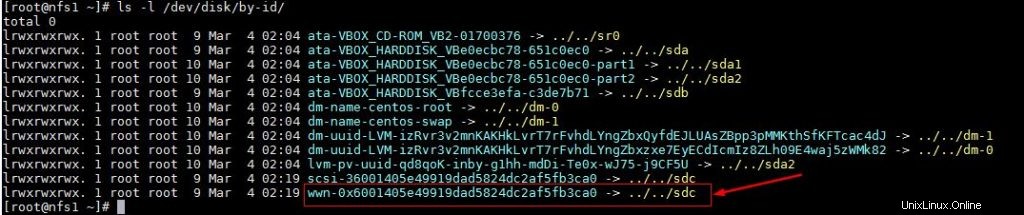

Dalam tutorial ini kami menggunakan disk bersama berukuran 1 GB (/ dev/sdc) sebagai perangkat pagar. Cari tahu dulu id dari /dev/sdc disk

[[email protected] ~]# ls -l /dev/disk/by-id/

Catat id disk /dev/sdc seperti yang kita inginkan di “pcs stonith ” perintah.

Sekarang jalankan di bawah perintah “pcs stonith” dari salah satu node untuk membuat perangkat pagar (disk_fencing)

[[email protected] ~]# pcs stonith create disk_fencing fence_scsi \ pcmk_host_list="nfs1.example.com nfs2.example.com" \ pcmk_monitor_action="metadata" pcmk_reboot_action="off" \ devices="/dev/disk /by-id/wwn-0x6001405e49919dad5824dc2af5fb3ca0" \ meta menyediakan="unfencing"[[email protected] ~]#Verifikasi status stonith menggunakan perintah di bawah ini,

[[email protected] ~]# pcs stonith show disk_fencing (stonith:fence_scsi): Memulai nfs1.example.com[[email protected] ~]#Jalankan “status pcs ” perintah untuk melihat status cluster

[[email protected] ~]# pcs statusCluster name:nfs_clusterStack:corosyncCurrent DC:nfs2.example.com (versi 1.1.16-12.el7_4.7-94ff4df) \ - partisi dengan quorumTerakhir diperbarui:Minggu Mar 4 03 :18:47 2018Perubahan terakhir:Minggu 4 Mar 03:16:09 2018 oleh root melalui cibadmin pada nfs1.example.com2 node yang dikonfigurasi1 resource dikonfigurasiOnline:[ nfs1.example.com nfs2.example.com ]Daftar lengkap sumber daya: disk_fencing ( stonith:fence_scsi): Memulai nfs1.example.comDaemon Status: corosync:active/enabled alat pacu jantung:active/enabled pcsd:active/enabled[[email protected] ~]#Catatan: Jika node cluster Anda adalah mesin Virtual dan dihosting di VMware, maka Anda dapat menggunakan “fence_vmware_soap ” agen pagar. Untuk mengonfigurasi “fence_vmware_soap” sebagai agen pagar, lihat langkah-langkah logis di bawah ini:

1) Verifikasi apakah node cluster Anda dapat menjangkau VMware hypervisor atau Vcenter

# fence_vmware_soap -a-l -p \ --ssl -z -v -o list |egrep "(nfs1.example.com|nfs2.example.com)"atau# pagar_vmware_soap -a -l -p \ --ssl -z -o daftar |egrep "(nfs1.example.com|nfs2.example.com)" jika Anda dapat melihat nama VM di output maka tidak apa-apa, jika tidak, Anda perlu memeriksa mengapa node cluster tidak dapat membuat koneksi esxi atau vcenter.

2) Tentukan perangkat pagar menggunakan perintah di bawah ini,

# pcs stonith create vmware_fence fence_vmware_soap \ pcmk_host_map="node1:nfs1.example.com;node2:nfs2.example.com" \ ipaddr=ssl=1 login= passwd= 3) periksa status stonith menggunakan perintah di bawah ini,

# pcs stonith showLangkah 5) Instal nfs dan format disk bersama nfs

Instal paket 'nfs-utils' di kedua server nfs

[[email protected] ~]# yum install nfs-utils -y[[email protected] ~]# yum install nfs-utils -yHentikan dan nonaktifkan “nfs-lock . lokal ” layanan di kedua node karena layanan ini akan dikendalikan oleh alat pacu jantung

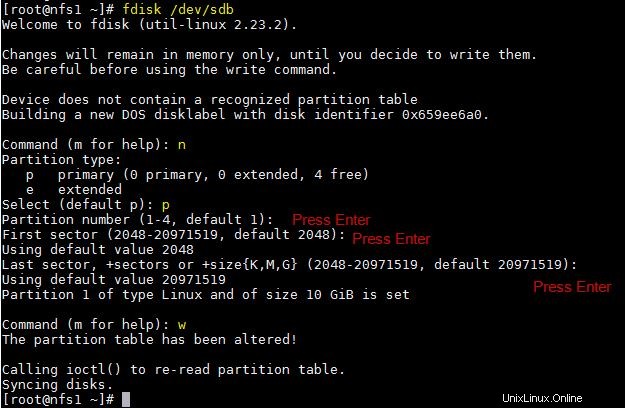

[[email protected] ~]# systemctl stop nfs-lock && systemctl disable nfs-lock[[email protected] ~]# systemctl stop nfs-lock && systemctl disable nfs-lockMari kita asumsikan kita memiliki disk bersama “/ dev/sdb” berukuran 10 GB antara dua node cluster, Buat partisi di atasnya dan format sebagai sistem file xfs

[[email protected] ~]# fdisk /dev/sdb

Jalankan perintah partprobe pada kedua node dan reboot sekali.

~]# partprobeSekarang format “/dev/sdb1” sebagai sistem file xfs

[[email dilindungi] ~]# mkfs.xfs/dev/sdb1meta-data =/dev/sdb1 ISIZE =256 AgCount =4, agSize =655296 BLKS =SectSZ =512 ATTR =2, Projid32bit =1 =CRC =0 finobt =0data =bsize =4096 blok =2621184, IMAXPCT =25 =sunit =0 swidth =0 blksnaming =versi 2 bsize =4096 ascii-ci =0 ftype =0log =log internal bsize =4096 blok =2560, versi =2 = sectsz=512 sunit=0 blks, lazy-count=1realtime =none extsz=4096 blocks=0, rtextents=0[[email protected] ~]# Buat titik mount untuk sistem file ini di kedua node,

[[email protected] ~]# mkdir /nfsshare[[email protected] ~]# mkdir /nfsshareLangkah 6) Konfigurasikan semua sumber daya NFS yang diperlukan di Cluster Nodes

Berikut ini adalah sumber daya NFS yang diperlukan:

- Sumber daya sistem file

- sumber daya nfsserver

- mengekspor sumber daya

- Sumber daya alamat IP mengambang IPaddr2

Untuk sumber daya Filesystem, kami memerlukan penyimpanan bersama di antara node cluster, kami telah membuat partisi pada disk bersama (/ dev/sdb1) pada langkah-langkah di atas, jadi kami akan menggunakan partisi itu. Gunakan di bawah “buatan sumber daya pcs ” perintah untuk mendefinisikan sumber daya Filesystem dari node mana pun,

[[email protected] ~]# pcs resource create nfsshare Filesystem device=/dev/sdb1 \ directory=/nfsshare fstype=xfs --group nfsgrp[[email protected] ~]#Dalam perintah di atas kami telah mendefinisikan sistem file NFS sebagai “nfsshare ” di bawah grup “nfsgrp “. Sekarang dan seterusnya semua sumber daya nfs akan dibuat di bawah grup nfsgrp.

Buat sumber daya nfsserver dengan nama ‘nfsd ' menggunakan perintah di bawah ini,

[[email protected] ~]# pcs resource buat nfsd nfsserver \ nfs_shared_infodir=/nfsshare/nfsinfo --group nfsgrp[[email protected] ~]#Buat ekspor sumber daya dengan nama “nfsroot ”

[[email protected] ~]# pcs resource create nfsroot exportfs clientspec="192.168.1.0/24" options=rw,sync,no_root_squash directory=/nfsshare fsid=0 --group nfsgrp[[email protected] ~] #Pada perintah di atas, clientspec menunjukkan klien yang diizinkan yang dapat mengakses nfsshare

Buat NFS IPaddr2 sumber daya menggunakan perintah di bawah ini,

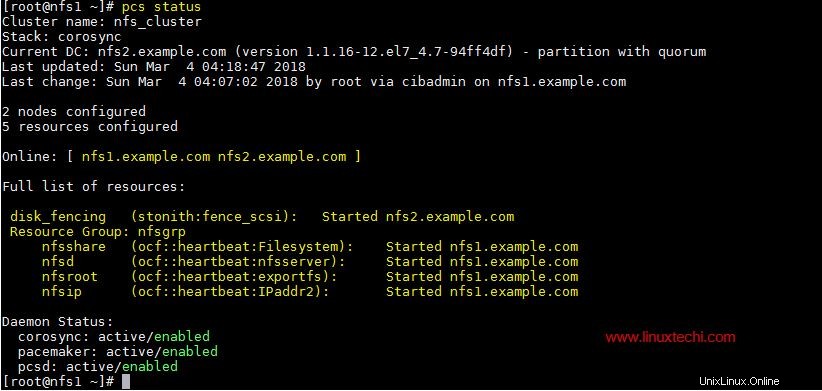

[[email protected] ~]# pcs resource create nfsip IPaddr2 ip=192.168.1.51 \ cidr_netmask=24 --group nfsgrp[[email protected] ~]#Sekarang lihat dan verifikasi cluster menggunakan status pcs

[[email protected] ~]# pcs status

Setelah Anda selesai dengan sumber daya NFS, izinkan port server nfs di firewall OS dari kedua server nfs,

~]# firewall-cmd --permanent --add-service=nfs~]# firewall-cmd --permanent --add-service=mountd~]# firewall-cmd --permanent --add-service=rpc-bind~]# firewall-cmd --reloadLangkah 7) Coba Pasang berbagi NFS di Klien

Sekarang coba mount share nfs menggunakan perintah mount, contoh di bawah ini

[[email protected] ~]# mkdir /mnt/nfsshare[[email protected] ~]# mount 192.168.1.51:/ /mnt/nfsshare/[[email protected] ~]# df -Th /mnt/nfsshareFilesystem Jenis Ukuran Digunakan Tersedia Penggunaan% Dipasang pada192.168.1.51:/ nfs4 10G 32M 10G 1% /mnt/nfsshare[[email protected] ~]#[[email protected] ~]# cd /mnt/nfsshare/[[email protected] ] nfsshare]# lsnfsinfo[[email protected] nfsshare]#Untuk pengujian Cluster, hentikan layanan cluster di salah satu node dan lihat apakah nfsshare dapat diakses atau tidak. Mari kita asumsikan saya akan menghentikan layanan cluster di “nfs1.example.com”

[[email protected] ~]# pcs cluster stopMenghentikan Cluster (alat pacu jantung)...Menghentikan Cluster (corosync)...[[email protected] ~]#Sekarang masuk ke mesin klien dan lihat apakah nfsshare masih dapat diakses, Dalam kasus saya, saya masih dapat mengaksesnya dan dapat membuat file di dalamnya.

[[email protected] nfsshare]# tes sentuh[[email protected] nfsshare]#Sekarang aktifkan layanan cluster di “nfs1.example.com” menggunakan perintah di bawah ini,

[[email protected] ~]# pcs cluster startMemulai Cluster...[[email protected] ~]#Itu saja dari artikel ini, ini mengonfirmasi bahwa kami telah berhasil mengonfigurasi pengelompokan aktif-pasif NFS menggunakan alat pacu jantung. Silakan bagikan umpan balik dan komentar Anda di bagian komentar di bawah.

Cara Menghubungkan mesin Windows dengan RDP dari Konsol CentOS 7 / RHEL 7 Cara menerapkan TripleO Overcloud (Pengontrol, Hitung) pada VM CentOS 7Cent OS