Dalam tutorial ini, kami akan menunjukkan kepada Anda cara menginstal Apache Spark di Debian 11. Bagi Anda yang belum tahu, Apache Spark adalah aplikasi gratis, open-source, dan serba guna. kerangka kerja untuk komputasi berkerumun. Ini dirancang khusus untuk kecepatan dan digunakan dalam pembelajaran mesin untuk streaming pemrosesan ke kueri SQL yang kompleks. Ini mendukung beberapa API untuk streaming, pemrosesan grafik termasuk, Java, Python, Scala, dan R. Spark sebagian besar diinstal di Hadoop cluster tetapi Anda juga dapat menginstal dan mengonfigurasi spark dalam mode mandiri.

Artikel ini mengasumsikan Anda memiliki setidaknya pengetahuan dasar tentang Linux, tahu cara menggunakan shell, dan yang terpenting, Anda meng-host situs Anda di VPS Anda sendiri. Instalasi cukup sederhana dan mengasumsikan Anda sedang berjalan di akun root, jika tidak, Anda mungkin perlu menambahkan 'sudo ' ke perintah untuk mendapatkan hak akses root. Saya akan menunjukkan kepada Anda melalui langkah-demi-langkah instalasi Apache Spark pada Debian 11 (Bullseye).

Prasyarat

- Server yang menjalankan salah satu sistem operasi berikut:Debian 11 (Bullseye).

- Sebaiknya Anda menggunakan penginstalan OS baru untuk mencegah potensi masalah.

- Seorang

non-root sudo useratau akses keroot user. Kami merekomendasikan untuk bertindak sebagainon-root sudo user, namun, karena Anda dapat membahayakan sistem jika tidak berhati-hati saat bertindak sebagai root.

Instal Apache Spark di Debian 11 Bullseye

Langkah 1. Sebelum menginstal perangkat lunak apa pun, penting untuk memastikan sistem Anda mutakhir dengan menjalankan apt berikut perintah di terminal:

sudo apt update sudo apt upgrade

Langkah 2. Menginstal Java.

Jalankan perintah berikut di bawah ini untuk menginstal Java dan dependensi lainnya:

sudo apt install default-jdk scala git

Verifikasi instalasi Java menggunakan perintah:

java --version

Langkah 3. Menginstal Apache Spark di Debian 11.

Sekarang kami mengunduh versi terbaru Apache Spark dari halaman resmi menggunakan wget perintah:

wget https://dlcdn.apache.org/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz

Selanjutnya, ekstrak file yang diunduh:

tar -xvzf spark-3.1.2-bin-hadoop3.2.tgz mv spark-3.1.2-bin-hadoop3.2/ /opt/spark

Setelah itu, edit ~/.bashrc file dan tambahkan variabel jalur Spark:

nano ~/.bashrc

Tambahkan baris berikut:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Simpan dan tutup file, lalu aktifkan variabel lingkungan Spark menggunakan perintah berikut di bawah ini:

source ~/.bashrc

Langkah 3. Mulai Apache Spark Master Server.

Pada titik ini, Apache spark telah diinstal. Sekarang mari kita mulai server master mandirinya dengan menjalankan skripnya:

start-master.sh

Secara default, Apache Spark mendengarkan pada port 8080. Anda dapat memeriksanya dengan perintah berikut:

ss -tunelp | grep 8080

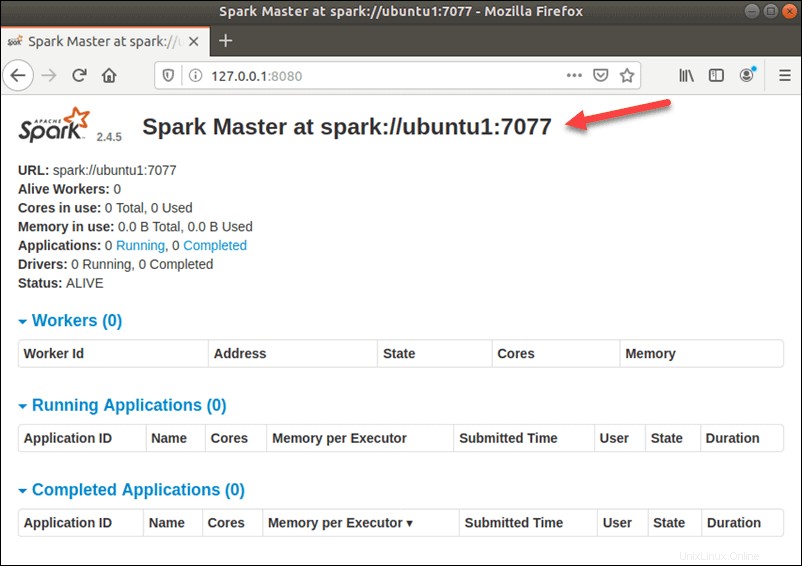

Langkah 4. Mengakses Antarmuka Web Apache Spark.

Setelah berhasil dikonfigurasi, sekarang akses antarmuka web Apache Spark menggunakan URL http://your-server-ip-address:8080 . Anda akan melihat layanan master dan slave Apache Spark pada layar berikut:

Dalam konfigurasi server tunggal dan mandiri ini, kita akan memulai satu server budak bersama dengan server master. start-slave.sh perintah yang digunakan untuk memulai Proses Spark Worker:

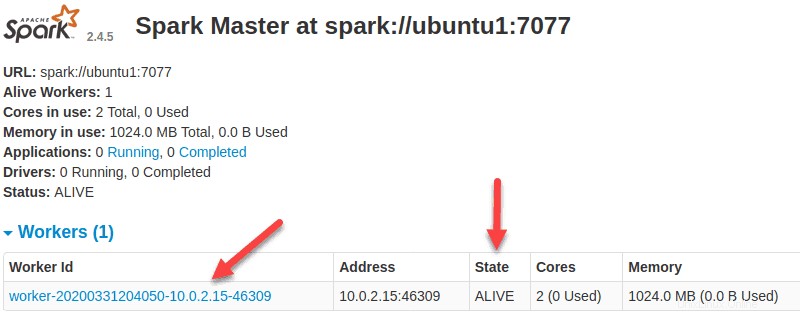

start-slave.sh spark://ubuntu1:7077

Sekarang pekerja sudah aktif dan berjalan, jika Anda memuat ulang UI Web Spark Master, Anda akan melihatnya di daftar:

Setelah menyelesaikan konfigurasi, mulai server master dan slave, uji apakah shell Spark berfungsi:

spark-shell

Anda akan mendapatkan antarmuka berikut:

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 3.1.2

/_/

Using Scala version 2.12.10 (OpenJDK 64-Bit Server VM, Java 11.0.12)

Type in expressions to have them evaluated.

Type :help for more information.

scala> Selamat! Anda telah berhasil menginstal Apache Spark. Terima kasih telah menggunakan tutorial ini untuk menginstal versi terbaru Apache Spark di Debian 11 Bullseye. Untuk bantuan tambahan atau informasi berguna, kami sarankan Anda memeriksa resmi Situs web Apache Spark.