Apache Spark adalah kerangka kerja komputasi gratis, open-source, tujuan umum, dan terdistribusi yang dibuat untuk memberikan hasil komputasi yang lebih cepat. Ini mendukung beberapa API untuk streaming, pemrosesan grafik termasuk, Java, Python, Scala, dan R. Secara umum, Apache Spark dapat digunakan di cluster Hadoop, tetapi Anda juga dapat menginstalnya dalam mode mandiri.

Dalam tutorial ini, kami akan menunjukkan cara menginstal framework Apache Spark di Debian 11.

Prasyarat

- Server yang menjalankan Debian 11.

- Kata sandi root dikonfigurasi di server.

Instal Java

Apache Spark ditulis dalam Java. Jadi Java harus diinstal di sistem Anda. Jika belum terinstal, Anda dapat menginstalnya menggunakan perintah berikut:

apt-get install default-jdk curl -y

Setelah Java diinstal, verifikasi versi Java menggunakan perintah berikut:

java --version

Anda akan mendapatkan output berikut:

openjdk 11.0.12 2021-07-20 OpenJDK Runtime Environment (build 11.0.12+7-post-Debian-2) OpenJDK 64-Bit Server VM (build 11.0.12+7-post-Debian-2, mixed mode, sharing)

Instal Apache Spark

Pada saat penulisan tutorial ini, versi terbaru Apache Spark adalah 3.1.2. Anda dapat mengunduhnya menggunakan perintah berikut:

wget https://dlcdn.apache.org/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz

Setelah unduhan selesai, ekstrak file yang diunduh dengan perintah berikut:

tar -xvzf spark-3.1.2-bin-hadoop3.2.tgz

Selanjutnya pindahkan direktori hasil ekstrak ke /opt dengan perintah berikut:

mv spark-3.1.2-bin-hadoop3.2/ /opt/spark

Selanjutnya, edit file ~/.bashrc dan tambahkan variabel jalur Spark:

nano ~/.bashrc

Tambahkan baris berikut:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Simpan dan tutup file kemudian aktifkan variabel lingkungan Spark menggunakan perintah berikut:

source ~/.bashrc

Mulai Apache Spark

Anda sekarang dapat menjalankan perintah berikut untuk memulai layanan master Spark:

start-master.sh

Anda akan mendapatkan output berikut:

starting org.apache.spark.deploy.master.Master, logging to /opt/spark/logs/spark-root-org.apache.spark.deploy.master.Master-1-debian11.out

Secara default, Apache Spark mendengarkan pada port 8080. Anda dapat memverifikasinya menggunakan perintah berikut:

ss -tunelp | grep 8080

Anda akan mendapatkan output berikut:

tcp LISTEN 0 1 *:8080 *:* users:(("java",pid=24356,fd=296)) ino:47523 sk:b cgroup:/user.slice/user-0.slice/session-1.scope v6only:0 <->

Selanjutnya, mulai proses pekerja Apache Spark menggunakan perintah berikut:

start-slave.sh spark://your-server-ip:7077

Mengakses Apache Spark Web UI

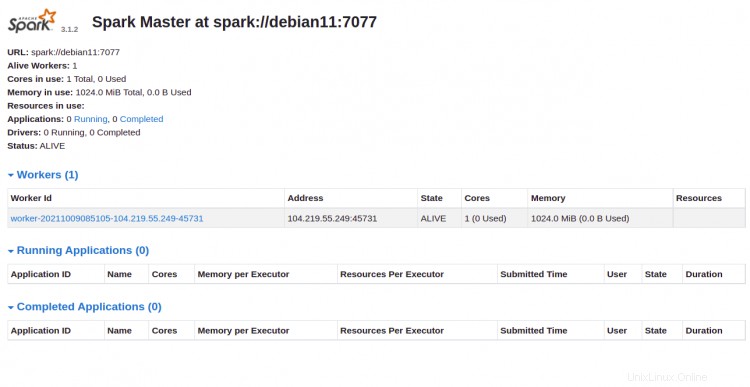

Anda sekarang dapat mengakses antarmuka web Apache Spark menggunakan URL http://your-server-ip:8080 . Anda akan melihat layanan master dan slave Apache Spark pada layar berikut:

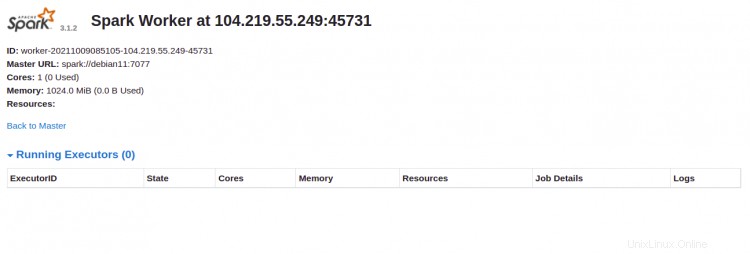

Klik Pekerja Indo. Anda akan melihat informasi detail Pekerja Anda di layar berikut:

Hubungkan Apache Spark melalui Command-line

Jika Anda ingin terhubung ke Spark melalui shell perintahnya, jalankan perintah di bawah ini:

spark-shell

Setelah Anda terhubung, Anda akan mendapatkan antarmuka berikut:

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 3.1.2

/_/

Using Scala version 2.12.10 (OpenJDK 64-Bit Server VM, Java 11.0.12)

Type in expressions to have them evaluated.

Type :help for more information.

scala>

Jika Anda ingin menggunakan Python di Spark. Anda dapat menggunakan utilitas baris perintah pyspark.

Pertama, instal Python versi 2 dengan perintah berikut:

apt-get install python -y

Setelah terinstal, Anda dapat menghubungkan Spark dengan perintah berikut:

pyspark

Setelah terhubung, Anda akan mendapatkan output berikut:

To adjust logging level use sc.setLogLevel(newLevel). For SparkR, use setLogLevel(newLevel).

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/__ / .__/\_,_/_/ /_/\_\ version 3.1.2

/_/

Using Python version 3.9.2 (default, Feb 28 2021 17:03:44)

Spark context Web UI available at http://debian11:4040

Spark context available as 'sc' (master = local[*], app id = local-1633769632964).

SparkSession available as 'spark'.

>>>

Hentikan Master dan Slave

Pertama, hentikan proses slave menggunakan perintah berikut:

stop-slave.sh

Anda akan mendapatkan output berikut:

stopping org.apache.spark.deploy.worker.Worker

Selanjutnya, hentikan proses master menggunakan perintah berikut:

stop-master.sh

Anda akan mendapatkan output berikut:

stopping org.apache.spark.deploy.master.Master

Kesimpulan

Selamat! Anda telah berhasil menginstal Apache Spark di Debian 11. Sekarang Anda dapat menggunakan Apache Spark di organisasi Anda untuk memproses kumpulan data besar