Dalam tutorial ini, kami akan menunjukkan cara menginstal Apache Spark di Debian 10. Bagi Anda yang belum tahu, Apache Spark adalah sistem komputasi cluster yang cepat dan serba guna. Ini menyediakan API tingkat tinggi di Java, Scala, dan Python, dan juga mesin yang dioptimalkan yang mendukung grafik eksekusi secara keseluruhan. Ini juga mendukung serangkaian alat tingkat tinggi yang kaya termasuk Spark SQL untuk SQL dan pemrosesan informasi terstruktur, MLlib untuk pembelajaran mesin , GraphX untuk pemrosesan grafik, dan Spark Streaming.

Artikel ini mengasumsikan Anda memiliki setidaknya pengetahuan dasar tentang Linux, tahu cara menggunakan shell, dan yang terpenting, Anda meng-host situs Anda di VPS Anda sendiri. Instalasi cukup sederhana dan mengasumsikan Anda sedang berjalan di akun root, jika tidak, Anda mungkin perlu menambahkan 'sudo ' ke perintah untuk mendapatkan hak akses root. Saya akan menunjukkan kepada Anda melalui langkah-demi-langkah instalasi Apache Spark pada Debian 10 (Buster).

Prasyarat

- Server yang menjalankan salah satu sistem operasi berikut:Debian 10 (Buster).

- Sebaiknya Anda menggunakan penginstalan OS baru untuk mencegah potensi masalah.

- Seorang

non-root sudo useratau akses keroot user. Kami merekomendasikan untuk bertindak sebagainon-root sudo user, namun, karena Anda dapat membahayakan sistem jika tidak berhati-hati saat bertindak sebagai root.

Instal Apache Spark di Debian 10 Buster

Langkah 1. Sebelum menjalankan tutorial di bawah ini, penting untuk memastikan sistem Anda mutakhir dengan menjalankan apt berikut perintah di terminal:

sudo apt update

Langkah 2. Menginstal Java.

Apache Spark membutuhkan Java untuk dijalankan, mari pastikan Java telah terinstal di sistem Debian kita:

sudo apt install default-jdk

Verifikasi versi Java menggunakan perintah:

java -version

Langkah 3. Menginstal Scala.

Sekarang kita menginstal paket Scala pada sistem Debian:

sudo apt install scala

Periksa versi Scala:

scala -version

Langkah 4. Menginstal Apache Spark di Debian.

Sekarang kita dapat mengunduh biner Apache Spark:

wget https://www.apache.org/dyn/closer.lua/spark/spark-3.1.1/spark-3.1.1-bin-hadoop2.7.tgz

Selanjutnya, ekstrak tarball Spark:

tar xvf spark-3.1.1-bin-hadoop2.7.tgz sudo mv spark-3.1.1-bin-hadoop2.7/ /opt/spark

Setelah selesai, setel lingkungan Spark:

nano ~/.bashrc

Di akhir file, tambahkan baris berikut:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Simpan perubahan dan tutup editor. Untuk menerapkan perubahan, jalankan:

source ~/.bashrc

Sekarang jalankan Apache Spark dengan perintah ini, salah satunya adalah master cluster:

start-master.sh

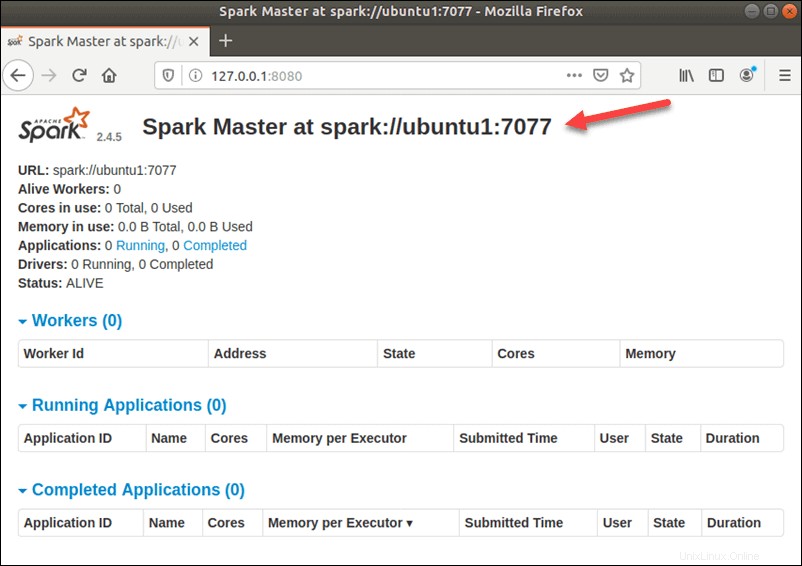

Untuk melihat tampilan antarmuka pengguna Spark Web seperti di bawah ini, buka web browser dan masukkan alamat IP localhost pada port 8080:

http://127.0.0.1:8080/

Dalam konfigurasi server tunggal dan mandiri ini, kita akan memulai satu server budak bersama dengan server master. start-slave.sh perintah digunakan untuk memulai Proses Spark Worker:

start-slave.sh spark://ubuntu1:7077

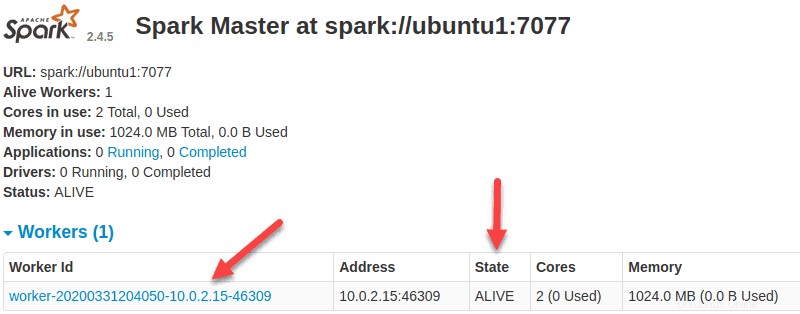

Sekarang pekerja sudah aktif dan berjalan, jika Anda memuat ulang UI Web Spark Master, Anda akan melihatnya di daftar:

Setelah menyelesaikan konfigurasi, mulai server master dan slave, uji apakah shell Spark berfungsi:

spark-shell

Selamat! Anda telah berhasil menginstal Spark. Terima kasih telah menggunakan tutorial ini untuk menginstal versi terbaru Apache Spark pada sistem Debian. Untuk bantuan tambahan atau informasi berguna, kami sarankan Anda memeriksa Apache resmi Situs web Spark.