Apache Spark adalah kerangka kerja komputasi klaster sumber terbuka dan gratis yang digunakan untuk analitik, pembelajaran mesin, dan pemrosesan grafik pada volume data yang besar. Spark hadir dengan 80+ operator tingkat tinggi yang memungkinkan Anda membuat aplikasi paralel dan menggunakannya secara interaktif dari shell Scala, Python, R, dan SQL. Ini adalah mesin pemrosesan data dalam memori secepat kilat yang dirancang khusus untuk ilmu data. Ini menyediakan serangkaian fitur yang kaya termasuk, Kecepatan, Toleransi kesalahan, Pemrosesan aliran waktu nyata, Komputasi dalam memori, Analisis lanjutan, dan banyak lagi.

Dalam tutorial ini, kami akan menunjukkan cara menginstal Apache Spark di server Debian 10.

Prasyarat

- Server yang menjalankan Debian 10 dengan RAM 2 GB.

- Kata sandi root dikonfigurasi di server Anda.

Memulai

Sebelum memulai, disarankan untuk memperbarui server Anda dengan versi terbaru. Anda dapat memperbaruinya menggunakan perintah berikut:

apt-get update -y

apt-get upgrade -y

Setelah server Anda diperbarui, mulai ulang untuk menerapkan perubahan.

Instal Java

Apache Spark ditulis dalam bahasa Java. Jadi, Anda perlu menginstal Java di sistem Anda. Secara default, versi terbaru Java tersedia di repositori default Debian 10. Anda dapat menginstalnya menggunakan perintah berikut:

apt-get install default-jdk -y

Setelah menginstal Java, verifikasi versi Java yang diinstal menggunakan perintah berikut:

java --version

Anda akan mendapatkan output berikut:

openjdk 11.0.5 2019-10-15 OpenJDK Runtime Environment (build 11.0.5+10-post-Debian-1deb10u1) OpenJDK 64-Bit Server VM (build 11.0.5+10-post-Debian-1deb10u1, mixed mode, sharing)

Unduh Apache Spark

Pertama, Anda perlu mengunduh versi terbaru Apache Spark dari situs resminya. Pada saat penulisan artikel ini, versi terbaru Apache Spark adalah 3.0. Anda dapat mengunduhnya ke direktori /opt dengan perintah berikut:

cd /opt

wget http://apachemirror.wuchna.com/spark/spark-3.0.0-preview2/spark-3.0.0-preview2-bin-hadoop2.7.tgz

Setelah unduhan selesai, ekstrak file yang diunduh menggunakan perintah berikut:

tar -xvzf spark-3.0.0-preview2-bin-hadoop2.7.tgz

Selanjutnya, ganti nama direktori yang diekstraksi menjadi spark seperti yang ditunjukkan di bawah ini:

mv spark-3.0.0-preview2-bin-hadoop2.7 spark

Selanjutnya, Anda perlu mengatur lingkungan untuk Spark. Anda dapat melakukannya dengan mengedit file ~/.bashrc:

nano ~/.bashrc

Tambahkan baris berikut di akhir file:

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Simpan dan tutup file setelah Anda selesai. Kemudian, aktifkan lingkungan dengan perintah berikut:

source ~/.bashrc

Mulai Server Master

Anda sekarang dapat memulai server Master menggunakan perintah berikut:

start-master.sh

Anda akan mendapatkan output berikut:

starting org.apache.spark.deploy.master.Master, logging to /opt/spark/logs/spark-root-org.apache.spark.deploy.master.Master-1-debian10.out

Secara default, Apache Spark mendengarkan pada port 8080. Anda dapat memverifikasinya dengan perintah berikut:

netstat -ant | grep 8080

Keluaran:

tcp6 0 0 :::8080 :::* LISTEN

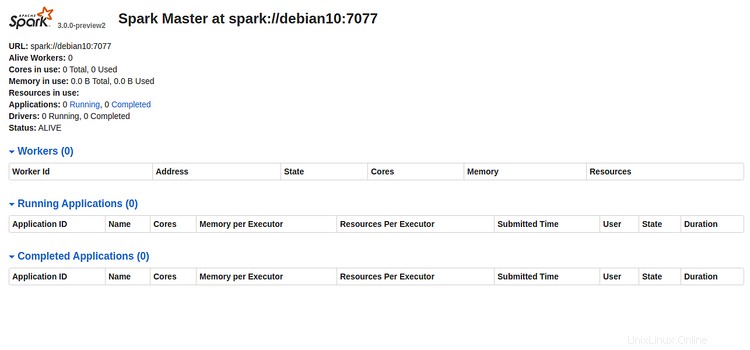

Sekarang, buka browser web Anda dan ketik URL http://server-ip-address:8080. Anda akan melihat halaman berikut:

Harap catat URL Spark "spark://debian10:7077 " dari gambar di atas. Ini akan digunakan untuk memulai proses pekerja Spark.

Mulai Proses Spark Worker

Sekarang, Anda dapat memulai proses pekerja Spark dengan perintah berikut:

start-slave.sh spark://debian10:7077

Anda akan mendapatkan output berikut:

starting org.apache.spark.deploy.worker.Worker, logging to /opt/spark/logs/spark-root-org.apache.spark.deploy.worker.Worker-1-debian10.out

Akses Spark Shell

Spark Shell adalah lingkungan interaktif yang menyediakan cara sederhana untuk mempelajari API dan menganalisis data secara interaktif. Anda dapat mengakses shell Spark dengan perintah berikut:

spark-shell

Anda akan melihat output berikut:

WARNING: An illegal reflective access operation has occurred

WARNING: Illegal reflective access by org.apache.spark.unsafe.Platform (file:/opt/spark/jars/spark-unsafe_2.12-3.0.0-preview2.jar) to constructor java.nio.DirectByteBuffer(long,int)

WARNING: Please consider reporting this to the maintainers of org.apache.spark.unsafe.Platform

WARNING: Use --illegal-access=warn to enable warnings of further illegal reflective access operations

WARNING: All illegal access operations will be denied in a future release

19/12/29 15:53:11 WARN NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Using Spark's default log4j profile: org/apache/spark/log4j-defaults.properties

Setting default log level to "WARN".

To adjust logging level use sc.setLogLevel(newLevel). For SparkR, use setLogLevel(newLevel).

Spark context Web UI available at http://debian10:4040

Spark context available as 'sc' (master = local[*], app id = local-1577634806690).

Spark session available as 'spark'.

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 3.0.0-preview2

/_/

Using Scala version 2.12.10 (OpenJDK 64-Bit Server VM, Java 11.0.5)

Type in expressions to have them evaluated.

Type :help for more information.

scala>

Dari sini, Anda dapat mempelajari cara memaksimalkan Apache Spark dengan cepat dan nyaman.

Jika Anda ingin menghentikan server Spark Master dan Slave, jalankan perintah berikut:

stop-slave.sh

stop-master.sh

Itu saja untuk saat ini, Anda telah berhasil menginstal Apache Spark di server Debian 10. Untuk informasi lebih lanjut, Anda dapat merujuk dokumentasi resmi Spark di Spark Doc.